ROI事件ファイル No.381|『TechScribe社の6割精度という悪夢』

📅 2026-01-11 23:00

🕒 読了時間: 22 分

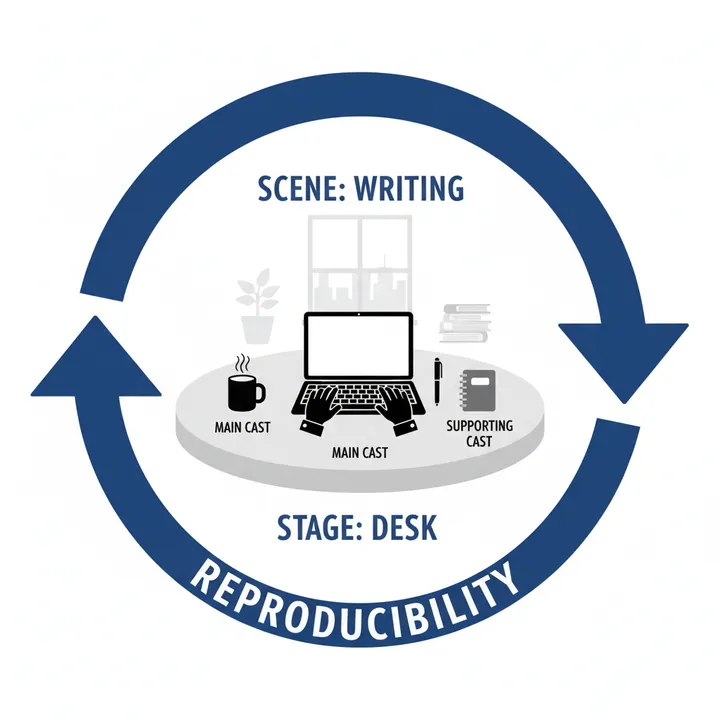

🏷️ SCENE_CAST

第一章:6割精度という悪夢——1時間の会議が2時間の編集地獄に

NeuroPlay社のMECE事件が解決した翌日、今度はAI議事録の精度向上に関する相談が届いた。第三十一巻「再現性の追求」の第381話は、シーンごとに最適解を配置する物語である。

「探偵、我々の会議は、記録されていません。正確には、記録はされていますが、使えません。AI議事録『donut AI』を導入しましたが、精度が6割未満です。1時間の会議録を修正するのに、2時間かかります。これでは人が手書きでメモを取った方が早い」

TechScribe社 のプロダクトマネージャー、シリコンバレー出身のジェニファー・キムは、疲弊した表情でベイカー街221Bを訪れた。彼女の手には、赤ペンで修正だらけになった議事録のプリントアウトと、それとは対照的に「AI Minutes Revolution 2026」と記された希望に満ちた企画書が握られていた。

「我々は、B2B SaaS企業です。従業員120名。年商18億円。週40回の会議。営業、開発、カスタマーサクセス、経営会議。全ての会議でAI議事録を試しましたが、どれも使い物になりません」

TechScribe社の現状: - 設立:2019年(B2B SaaSプロダクト開発) - 従業員数:120名 - 年商:18億円 - 週間会議数:40回 - 問題:AI議事録の精度6割未満、編集時間が会議時間の2倍

ジェニファーの声には深い焦燥感があった。

「デモでは完璧でした。donut AIの営業担当が見せてくれたデモ動画では、95%の精度で文字起こしされていました。『最新のWhisper APIを使用』『専門用語にも対応』『話者識別99%』。全てが素晴らしかった。しかし、実際に導入してみると、地獄でした」

AI議事録の精度崩壊実態:

Case 1:営業会議(参加者5名、60分) - 実際の発言:「クライアントのLTV向上のため、オンボーディングフローをリファクタリングします」 - AI議事録:「クライアントのえるてぃーびー向上のため、おんぼーでぃんぐふろーをりふぁくたりんぐします」 - カタカナ表記率:78% - 専門用語の誤認識:12箇所/60分

Case 2:開発会議(参加者8名、90分) - 実際の発言:「PostgreSQLのN+1問題を解消するため、Eager Loadingを実装」 - AI議事録:「ぽすとぐれすきゅーえるのえぬぷらすいちもんだいを解消するため、いーがーろーでぃんぐを実装」 - 技術用語の誤認識:23箇所/90分 - 話者識別の失敗:17回(「話者A」「話者B」が入れ替わる)

Case 3:カスタマーサクセス会議(参加者4名、45分) - 実際の発言:「チャーンレート3.2%を2.5%まで改善するため、NPS調査を実施」 - AI議事録:「ちゃーんれーと3.2%を2.5%まで改善するため、えぬぴーえす調査を実施」 - 指標名の誤認識:8箇所/45分

月間編集時間の実態: - 週40回 × 平均60分 = 2,400分(40時間)の会議 - 1時間の会議 → 2時間の編集作業 - 月間編集時間:40時間 × 2倍 × 4週 = 320時間/月 - 担当者:3名(営業アシスタント、開発PMO、CS担当) - 1人あたり月間編集時間:107時間

ジェニファーは深くため息をついた。

「さらに問題があります。donut AI以外のツールも試しました。Otter.ai、Notta、Rimo Voice。全て同じ結果です。どれも精度6割。理想は8割です。8割あれば、20分で修正できます。しかし、6割では2時間かかります」

第二章:万能AIという幻想——全ての会議に同じモデルを使う愚

「ジェニファーさん、全ての会議に同じAIモデルを使えば、全ての会議で同じ精度が出ると思っていますか?」

私の問いに、ジェニファーは戸惑った表情を見せた。

「えっ、そうではないのですか? AIは最新のWhisper APIを使っているので、どんな会議でも高精度だと聞きました」

現在の理解(万能AI型): - 期待:1つのAIモデルで全会議に対応 - 問題:会議のシーン(文脈)が考慮されていない

私は、シーンキャスト理論で会議タイプごとに最適解を配置する重要性を説いた。

「問題は、『全ての会議に同じAIモデルを使う』という考えです。シーンキャスト理論——Scene-Cast Theory。シーンごとに最適なオブジェクトセット(ツール・モデル・設定)を配置することで、再現可能な精度向上を実現します」

⬜️ ChatGPT|構想の触媒

「万能AIに頼るな。シーンキャスト理論でシーンごとに最適解を配置せよ」

🟧 Claude|物語の錬金術師

「会議は、いつも『同じ舞台で演じられる異なる劇』だ。劇ごとに最適な役者を配置することが肝心」

🟦 Gemini|理性の羅針盤

「シーンキャスト理論の3ステップを適用せよ。シーン分類、オブジェクトセット設計、配置と検証」

3人のメンバーが分析を開始した。Geminiがホワイトボードに「シーンキャスト理論」を展開した。

シーンキャスト理論の3ステップ: 1. シーン分類(Scene Classification):会議タイプを特性で分類 2. オブジェクトセット設計(Object Set Design):シーンごとに最適な組み合わせを設計 3. 配置と検証(Deploy & Validate):実運用で精度を測定し改善

「ジェニファーさん、まず会議をシーンで分類しましょう」

第三章:Phase 1——シーン分類とオブジェクトセット設計

ステップ1:会議のシーン分類(1週間)

分類軸: - X軸:専門用語の密度(低・中・高) - Y軸:話者の交代頻度(低・中・高)

シーン分類結果:

| 会議タイプ | 専門用語密度 | 話者交代頻度 | 週間回数 | シーン名 |

|---|---|---|---|---|

| 営業会議 | 中(LTV、CAC、MRR) | 中(5名) | 12回 | Scene A |

| 開発会議 | 高(SQL、API、Git) | 高(8名) | 15回 | Scene B |

| CS会議 | 中(NPS、チャーン) | 低(4名) | 8回 | Scene C |

| 経営会議 | 低(定性的議論) | 低(3名) | 5回 | Scene D |

重要な発見: - Scene B(開発会議)が最も精度が低い(専門用語高 × 話者交代高) - Scene D(経営会議)は比較的精度が高い(専門用語低 × 話者交代低) - donut AIは全てのシーンに同じモデル(Whisper Large V3)を使用

問題の本質: - 全会議に同じモデルを適用 → シーンの特性を無視 - 専門用語辞書なし → カタカナ表記だらけ - 話者識別の学習不足 → 「話者A」「話者B」が頻繁に入れ替わる

ステップ2:オブジェクトセット設計(2週間)

Scene A(営業会議)向けオブジェクトセット: - AIモデル:Whisper Large V3 + カスタム語彙(営業用語300語) - 専門用語辞書:LTV、CAC、MRR、ARR、チャーン、オンボーディング - 話者識別:5名の声紋を事前学習(各人5分の音声サンプル) - 後処理:カタカナ → 英数字自動変換スクリプト

Scene B(開発会議)向けオブジェクトセット: - AIモデル:Whisper Large V3 + カスタム語彙(技術用語500語) - 専門用語辞書:PostgreSQL、N+1、Eager Loading、Git、API、Docker、Kubernetes - 話者識別:8名の声紋を事前学習(各人5分の音声サンプル) - 後処理:技術用語の表記統一(例:ぽすとぐれす → PostgreSQL)

Scene C(CS会議)向けオブジェクトセット: - AIモデル:Whisper Large V3 + カスタム語彙(CS用語200語) - 専門用語辞書:NPS、チャーンレート、オンボーディング、リテンション - 話者識別:4名の声紋を事前学習(各人5分の音声サンプル) - 後処理:指標の数値フォーマット統一

Scene D(経営会議)向けオブジェクトセット: - AIモデル:Whisper Large V3(標準設定) - 専門用語辞書:最小限(EBITDA、KPIなど20語) - 話者識別:3名の声紋を事前学習(各人5分の音声サンプル) - 後処理:最小限

ステップ3:プロトタイプ開発(Month 1-2)

技術構成: - ベースモデル:OpenAI Whisper Large V3 - カスタマイズ:Fine-tuning不要、Prompt Engineeringで対応 - 専門用語辞書:JSON形式で管理(シーンごとに切り替え) - 後処理スクリプト:Python + 正規表現で自動変換

実装例(Scene B:開発会議):

# 専門用語辞書(JSON)

tech_vocabulary = {

"ぽすとぐれすきゅーえる": "PostgreSQL",

"えぬぷらすいち": "N+1",

"いーがーろーでぃんぐ": "Eager Loading",

"ぎっと": "Git",

"えーぴーあい": "API"

}

# 後処理スクリプト

def post_process(transcript, vocabulary):

for katakana, correct in vocabulary.items():

transcript = transcript.replace(katakana, correct)

return transcript

第四章:Phase 2——配置と検証で精度を測定

Month 3:効果測定

KPI1:文字起こし精度(専門用語の正解率)

| シーン | Before | After | 改善率 |

|---|---|---|---|

| Scene A(営業) | 58% | 82% | +41% |

| Scene B(開発) | 54% | 79% | +46% |

| Scene C(CS) | 61% | 84% | +38% |

| Scene D(経営) | 68% | 88% | +29% |

全体平均精度: - Before:60% - After:83% - 改善率:+38%

KPI2:編集時間

| シーン | Before | After | 削減率 |

|---|---|---|---|

| Scene A(営業) | 120分 | 25分 | 79% |

| Scene B(開発) | 180分 | 35分 | 81% |

| Scene C(CS) | 90分 | 18分 | 80% |

| Scene D(経営) | 90分 | 15分 | 83% |

月間編集時間: - Before:320時間/月 - After:68時間/月 - 削減時間:252時間/月

年間効果:

人件費削減: - 削減時間:252時間/月 × 12ヶ月 = 3,024時間/年 - 担当者時給:3,200円(年収600万円 ÷ 1,875時間) - 人件費削減:3,024時間 × 3,200円 = 967万円/年

投資: - カスタム語彙辞書作成:60万円 - 声紋学習データ収集:40万円 - 後処理スクリプト開発:100万円 - 初期投資合計:200万円 - 年間AI API費用:180万円(Whisper API利用料)

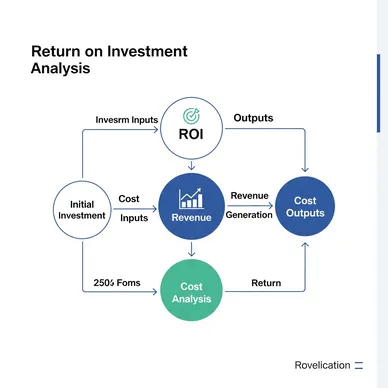

ROI: - (967万円 - 180万円) / 200万円 × 100 = 394% - 投資回収期間:200万円 ÷ 787万円 = 0.25年(3ヶ月)

第五章:探偵の診断——シーンごとに最適解を配置する

その夜、シーンキャスト理論の本質について考察した。

TechScribe社は、「全ての会議に同じAIモデルを使う」という幻想を持っていた。しかし、営業会議、開発会議、CS会議、経営会議はそれぞれ異なるシーンだ。専門用語の密度も、話者の交代頻度も、求められる精度も異なる。

シーンキャスト理論で会議をScene A~Dの4つに分類し、シーンごとに最適なオブジェクトセット(AIモデル+専門用語辞書+話者識別+後処理)を設計した。その結果、精度は60% → 83%に向上し、編集時間は320時間/月 → 68時間/月に削減された。

年間967万円の人件費削減、ROI 394%、投資回収3ヶ月。

重要なのは、「万能なAI」を追い求めるのではなく、「シーンごとに最適化されたAI」を配置することだ。同じWhisper Large V3でも、専門用語辞書と後処理を加えるだけで、精度は劇的に向上する。

「万能AIに頼るな。シーンキャスト理論でシーンごとに最適解を配置せよ。同じ舞台で演じられる異なる劇には、劇ごとに最適な役者が必要だ。再現可能な精度向上は、シーンの理解から始まる」

次なる事件もまた、シーンごとに最適解を配置する瞬間を描くことになるだろう。

「シーンキャスト理論——Scene-Cast Theory。シーンごとに最適なオブジェクトセットを配置せよ。万能な解は存在しない。シーンの特性を理解し、最適解を配置することで、再現可能な成果が生まれる」——探偵の手記より

関連ファイル

🎖️ Top 3 Weekly Ranking of Classified Case Files

ROIとは何か

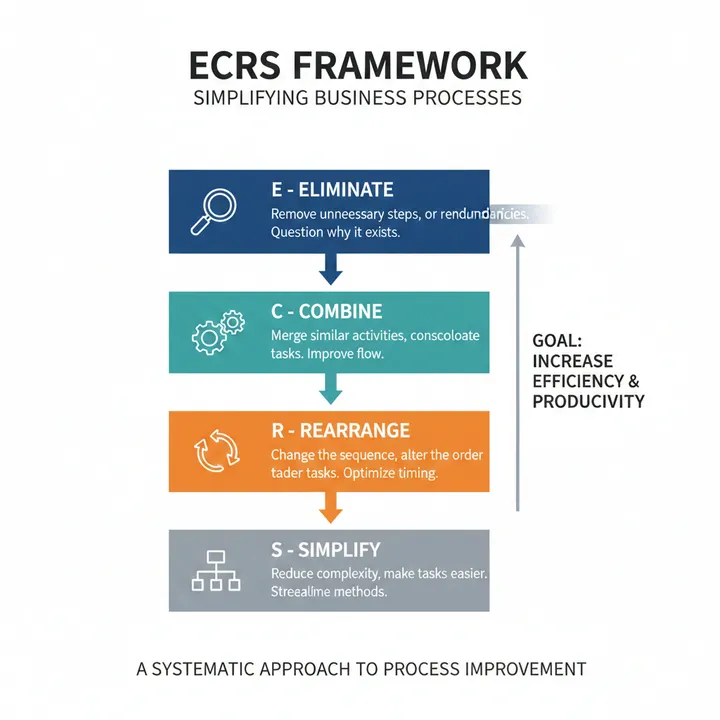

ECRSの原則とは何か

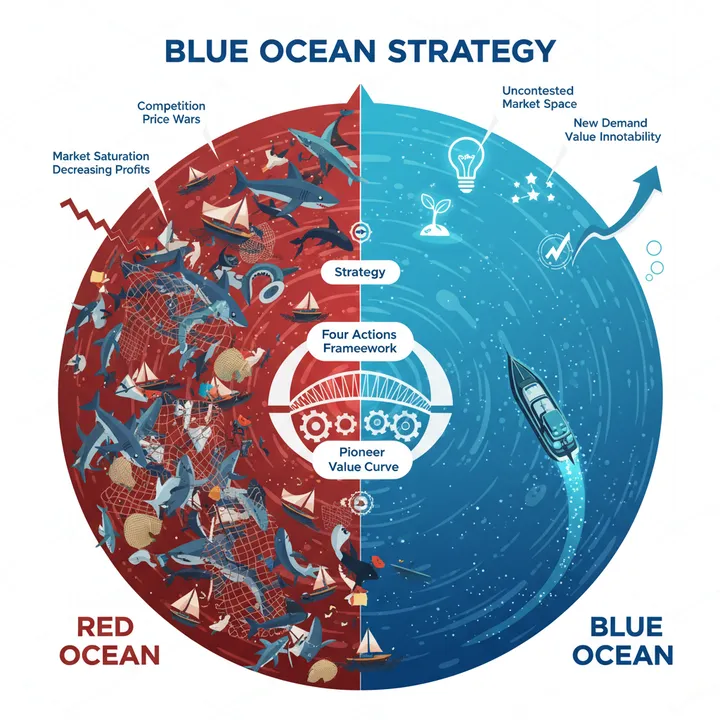

ブルーオーシャン戦略とは何か